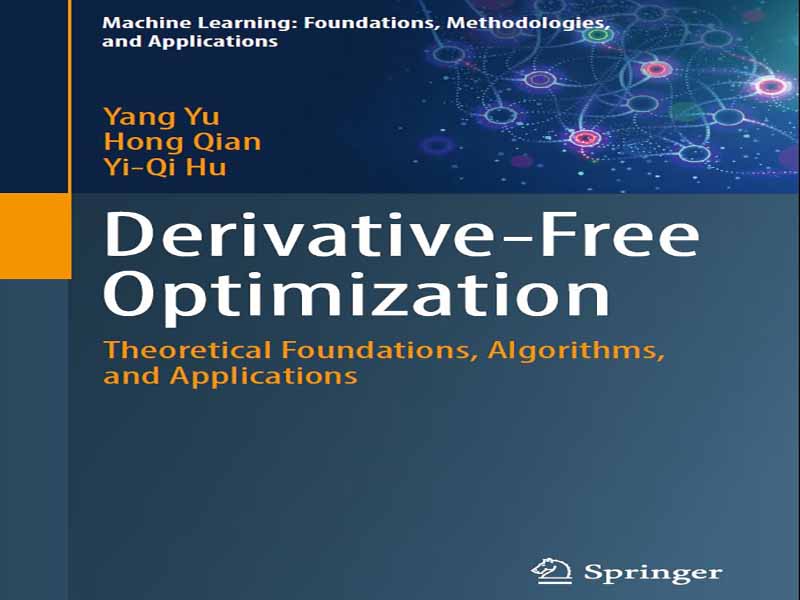

- عنوان کتاب: Derivative-Free Optimization -Theoretical Foundations, Algorithms, and Applications

- نویسنده: Yang Yu · Hong Qian · Yi-Qi Hu

- حوزه: نظریه ریاضی

- سال انتشار: 2025

- تعداد صفحه: 194

- زبان اصلی: انگلیسی

- نوع فایل: pdf

- حجم فایل: 6.40 مگابایت

پیگیری حل مسائل بهینهسازی از دیرباز سنگ بنای علوم کامپیوتر و هوش مصنوعی بوده است. در حالی که الگوریتمهای تخصصی متناسب با مسائل خاص توسعه یافتهاند، ظهور قابل توجهی از روشهای بهینهسازی عمومی نیز مشاهده شده است. این روشها، از جمله جستجوی تصادفی، شبیهسازی تبرید و الگوریتمهای تکاملی، اغلب بر اساس اصول اکتشافی ساخته میشوند. در نتیجه، خواص آنها عمدتاً از طریق مطالعات تجربی بررسی میشود و درک نظری جامع هنوز تا حد زیادی دور از دسترس است.

یانگ یو، نویسنده اول این تکنگاری، پیش از این کتابی با عنوان «یادگیری تکاملی: پیشرفت در نظریهها و الگوریتمها» را با پروفسور ژی-هوا ژو و چائو کیان به طور مشترک نوشته است که در سال ۲۰۱۹ توسط انتشارات اشپرینگر منتشر شد. در آن اثر، تمرکز نظری اصلی بر تحلیل زمان اجرا بود که زمان و پیچیدگی نمونه مورد نیاز برای یافتن یک راهحل بهینه را ارزیابی میکند. متعاقباً، یانگ به کاوش در مبانی نظری جایگزین برای روشهای بهینهسازی عمومی، که مکمل نظریههای جاافتاده یادگیری ماشین هستند، علاقه نشان داد. با توجه به اینکه یادگیری ماشینی توسط یک چارچوب آماری محکم پشتیبانی میشود، طبیعتاً این سوال مطرح میشود: آیا میتوانیم از منظر آماری، یک پایه نظری قوی مشابه برای روشهای بهینهسازی ایجاد کنیم؟ به طور خاص، چنین نظریهای میتواند توضیح دهد که چگونه این روشهای بهینهسازی، راهحلهای بهینه را تقریب میزنند.

با همکاری نویسنده دوم، هونگ چیان، که دانشجوی دکترای یانگ در سال ۲۰۱۳ بود، یک چارچوب اولیه توسعه داده شد. در ابتدا، این چارچوب برای برآورده کردن برخی از خواستههای نظری طراحی شد. به طور شگفتآوری، الگوریتم حاصل، عملکرد عملی رقابتی را نیز در برابر برخی از روشهای پیشرفته نشان داد. نویسنده سوم، یی-کی هو، که در سال ۲۰۱۵ دانشجوی دکترای یانگ شد، به تلاش برای اصلاح و گسترش بیشتر چارچوب و بهبود الگوریتم پیوست. این مونوگراف، مروری جامع بر تحقیقات نویسندگان ارائه میدهد که شامل توسعه چارچوب، طراحی الگوریتم و کاربردهای عملی است.

این مونوگراف به چهار بخش تقسیم شده است. بخش اول به طور خلاصه بهینهسازی بدون مشتق را در زمینه یادگیری ماشینی معرفی میکند. بخش دوم، چارچوب بهینهسازی مبتنی بر طبقهبندی را به همراه الگوریتم پایه آن ارائه میدهد. برای مقابله با چالشهای عملی مانند اجرای متوالی، ابعاد بالا، ارزیابیهای نویزی و اجرای موازی در مقیاس بزرگ، بخش سوم چندین نوع از الگوریتم پایه را معرفی میکند. این بخش همچنین شامل مقدمهای بر ZOOpt، یک جعبه ابزار بهینهسازی عمومی ساخته شده بر اساس الگوریتمهای بهینهسازی مبتنی بر طبقهبندی، است. بخش چهارم، کاربردهای مختلف بهینهسازی مبتنی بر طبقهبندی را در زمینه یادگیری ماشین خودکار، از جمله انتخاب فراپارامتر، انتخاب الگوریتم و جستجوی معماری عصبی، نشان میدهد.

نویسندگان از صمیم قلب از خانواده، دوستان و همکاران خود به خاطر حمایت و کمکهای بیدریغشان قدردانی میکنند.

The pursuit of solving optimization problems has long been a cornerstone in the realms of computer science and artificial intelligence. While specialized algorithms tailored to specific problems have been developed, there has also been a signifi-cant emergence of general-purpose optimization methods. These methods, including random search, simulated annealing, and evolutionary algorithms, are often crafted based on heuristic principles. Consequently, their properties are predominantly explored through empirical studies, with a comprehensive theoretical understanding still largely out of reach.

Yang Yu, the first author of this monograph, previously co-authored a book entitled Evolutionary Learning: Advances in Theories and Algorithms with Prof. Zhi-Hua Zhou and Chao Qian, which was published by Springer in 2019. In that work, the central theoretical focus was on running time analysis, which evaluates the time and sample complexity required to find an optimal solution. Subsequently, Yang devel-oped an interest in exploring alternative theoretical foundations for general-purpose optimization methods, complementing the well-established theories of machine learning. Given that machine learning is underpinned by a solid statistical frame-work, it naturally raises the question: can we establish a similarly strong theoret-ical foundation for optimization methods from a statistical perspective? Specifically, such a theory could elucidate how these optimization methods approximate optimal solutions.

Collaborating with the second author, Hong Qian, who was Yang’s Ph.D. student in 2013, a preliminary framework was developed. Initially, this framework was designed to meet certain theoretical desiderata. Surprisingly, the resulting algorithm also demonstrated competitive practical performance against some state-of-the-art methods. The third author, Yi-Qi Hu, who became Yang’s Ph.D. student in 2015, joined the effort to further refine and extend the framework and enhance the algo-rithm. This monograph provides a comprehensive overview of the authors’ research, encompassing the development of the framework, algorithm design, and practical applications.

The monograph is structured into four parts. Part I briefly introduces derivative-free optimization within the context of machine learning. Part II presents the classification-based optimization framework along with its basic algorithm. To tackle practical challenges such as sequential execution, high-dimensionality, noisy evalu-ations, and large-scale parallel execution, Part III introduces several variants of the basic algorithm. This part also includes an introduction to ZOOpt, a general opti-mization toolbox built on classification-based optimization algorithms. Part IV show-cases various applications of classification-based optimization in the field of auto-matic machine learning, including hyper-parameter selection, algorithm selection, and neural architecture search.

The authors extend their heartfelt gratitude to their families, friends, and collaborators for their unwavering support and contributions.

این کتاب را میتوانید از لینک زیر بصورت رایگان دانلود کنید:

Download: Derivative-Free Optimization

نظرات کاربران