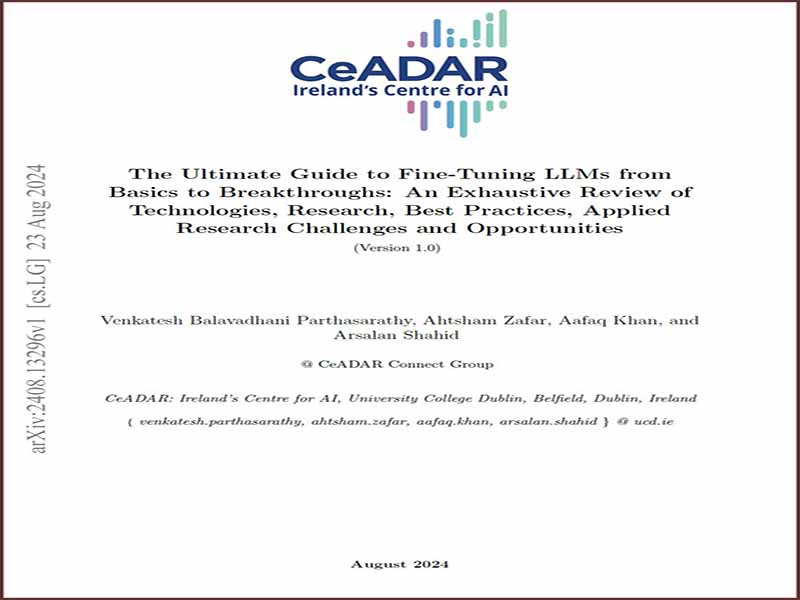

- عنوان کتاب: The Ultimate Guide to Fine-Tuning LLMs from Basics to Breakthrough

- نویسنده: Venkatesh Balavadhani Parthasarathy

- حوزه: مدل زبانی

- سال انتشار: 2024

- تعداد صفحه: 114

- زبان اصلی: انگلیسی

- نوع فایل: pdf

- حجم فایل: 15.1 مگابایت

این گزارش فنی به طور کامل فرآیند تنظیم دقیق مدلهای زبان بزرگ (LLMs)، ادغام بینشهای نظری و کاربردهای عملی را بررسی میکند. این کار با ردیابی توسعه تاریخی LLM آغاز میشود و بر تکامل آنها از مدلهای سنتی پردازش زبان طبیعی (NLP) و نقش محوری آنها در سیستمهای هوش مصنوعی مدرن تأکید میکند. این تجزیه و تحلیل بین روشهای تنظیم دقیق مختلف، از جمله رویکردهای نظارت شده، بدون نظارت و مبتنی بر دستورالعمل تمایز قائل میشود و بر مفاهیم مربوطه آنها برای وظایف خاص تأکید میکند. یک خط لوله هفت مرحله ای ساختاریافته برای تنظیم دقیق LLM معرفی شده است که چرخه حیات کامل از آماده سازی داده تا استقرار مدل را پوشش می دهد. ملاحظات کلیدی شامل استراتژیهای جمعآوری دادهها، مدیریت مجموعه دادههای نامتعادل، راهاندازی اولیه مدل، و تکنیکهای بهینهسازی، با تمرکز ویژه بر تنظیم فراپارامتر است. این گزارش همچنین روشهای تنظیم دقیق پارامتری کارآمد مانند تطبیق با رتبه پایین (LoRA) و نیمه تنظیم دقیق را برجسته میکند که محدودیتهای منبع را با عملکرد بهینه مدل متعادل میکند. این کاوش به تکنیکها و پیکربندیهای تنظیم دقیق پیشرفته مانند تنظیم دقیق حافظه، ترکیب کارشناسان (MoE) و ترکیب عوامل (MoA) گسترش مییابد، و نشان میدهد که چگونه این روشها شبکههای تخصصی و همکاری چند عاملی را برای نتایج بهتر مهار میکنند. بهینهسازی سیاست پروگزیمال (PPO) و بهینهسازی ترجیح مستقیم (DPO) به عنوان رویکردهای نوآورانه برای همسویی مدلها با ترجیحات انسانی مورد بحث قرار میگیرند، در حالی که مزایای هرس و بهینهسازی مسیریابی برای افزایش کارایی مورد بررسی قرار میگیرند. در بخشهای اخیر، گزارش به چارچوبهای اعتبارسنجی، نظارت پس از استقرار و تکنیکهای بهینهسازی برای استنتاج میپردازد. همچنین به استقرار LLM ها در پلتفرم های توزیع شده و مبتنی بر ابر می پردازد. علاوه بر این، موضوعات پیشرفته مانند LLM های چندوجهی و تنظیم دقیق برای پردازش صدا و گفتار، در کنار چالش های نوظهور مربوط به مقیاس پذیری، حریم خصوصی و مسئولیت پذیری پوشش داده شده است. هدف این گزارش این است که به عنوان یک راهنمای جامع برای محققان و متخصصان عمل کند و بینشهای عملی را در مورد تنظیم دقیق LLM ارائه دهد و در عین حال چالشها و فرصتهای ذاتی در این زمینه به سرعت در حال تحول را بررسی کند.

This technical report thoroughly examines the process of fine-tuning Large Language Models (LLMs), integrating theoretical insights and practical applications. It begins by tracing the historical development of LLMs, emphasising their evolution from traditional Natural Language Processing (NLP) models and their pivotal role in modern AI systems. The analysis differentiates between various fine-tuning methodologies, including supervised, unsupervised, and instruction-based approaches, underscoring their respective implications for specific tasks. A structured seven-stage pipeline for LLM fine-tuning is introduced, covering the complete lifecycle from data preparation to model deployment. Key considerations include data collection strategies, handling of imbalanced datasets, model initialisation, and optimisation techniques, with a particular focus on hyperparameter tuning. The report also highlights parameter-efficient fine-tuning methods such as Low-Rank Adaptation (LoRA) and Half Fine-Tuning, which balance resource constraints with optimal model performance. The exploration extends to advanced fine-tuning techniques and configurations like memory finetuning, Mixture of Experts (MoE) and Mixture of Agents (MoA), demonstrating how these methods harness specialised networks and multi-agent collaboration for improved outcomes. Proximal Policy Optimisation (PPO) and Direct Preference Optimisation (DPO) are discussed as innovative approaches to aligning models with human preferences, while the benefits of pruning and routing optimisations are examined for enhancing efficiency. In the latter sections, the report delves into validation frameworks, post-deployment monitoring, and optimisation techniques for inference. It also addresses the deployment of LLMs on distributed and cloud-based platforms. Additionally, cutting-edge topics such as multimodal LLMs and fine-tuning for audio and speech processing are covered, alongside emerging challenges related to scalability, privacy, and accountability. This report aims to serve as a comprehensive guide for researchers and practitioners, offering actionable insights into fine-tuning LLMs while navigating the challenges and opportunities inherent in this rapidly evolving field.

این کتاب را میتوانید از لینک زیر بصورت رایگان دانلود کنید:

Download: The Ultimate Guide to Fine-Tuning LLMs from Basics to Breakthrough

نظرات کاربران