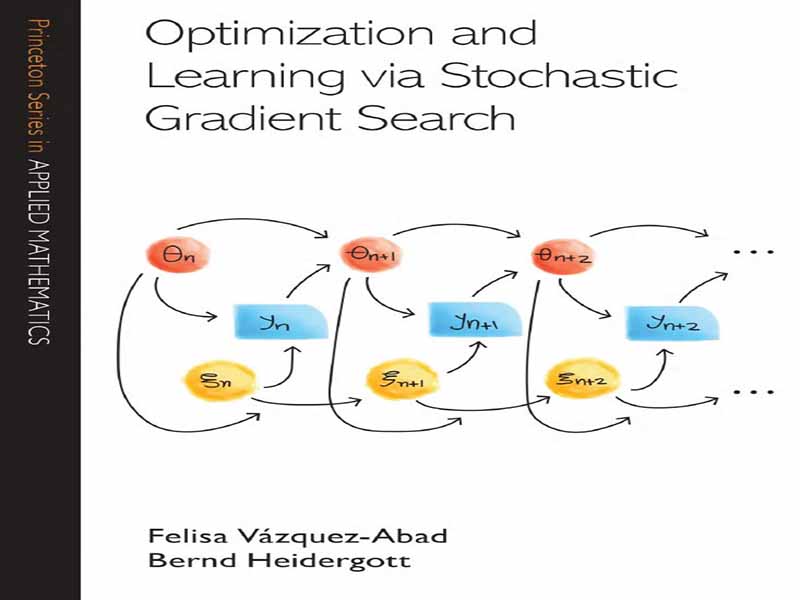

- عنوان کتاب: Optimization and Learning Via Stochastic Gradient Search

- نویسنده: Felisa V´azquez-Abad

- حوزه: یادگیری ماشین

- سال انتشار: 2025

- تعداد صفحه: 433

- زبان اصلی: انگلیسی

- نوع فایل: pdf

- حجم فایل: 3.21 مگابایت

این مونوگراف، بهینهسازی تصادفی و یادگیری را پوشش میدهد و عمدتاً بر روششناسی تقریبهای تصادفی و تکنیکهای تخمین گرادیان تمرکز دارد. ما بر مسائل پارامتر پیوسته تمرکز میکنیم و بهینهسازی گسسته را مورد بحث قرار نمیدهیم. رویکرد ما نظری است، اما تأکید بر الگوریتمهایی است که این روشها را پیادهسازی میکنند. بخش اول، بسیاری از کاربردهای مهم تقریبهای تصادفی را برای بهینهسازی و یادگیری که نیازی به استفاده از تخمین گرادیان ندارند، پوشش میدهد. بخش دوم، تخمین گرادیان را برای فرآیندهای تصادفی معرفی میکند که سپس دامنه کاربرد تقریبهای تصادفی را به طور قابل توجهی گسترش میدهد، که برخی از آنها در بخش سوم شرح داده شدهاند. تقریب تصادفی در دهههای گذشته به طور گسترده مورد بحث قرار گرفته است. برای بررسیهای کلی تقریب تصادفی، به Wasan [323]، Polyak و Tsypkin [250]، Ljung [205]، Kushner و Clark [193]، Polyak [248]، Bertsekas و Tsitsiklis [32، 33]، Bena¨im [24، 25]، Pflug [245]، Kushner و Yin [197]، Meyn [216]، Borkar [39] و Nemirovski و همکاران [226] مراجعه میکنیم. تخمین گرادیان در Ho و Cao [159]، Cao [58، 60]، Fu [101، 102]، Kroese و همکاران گنجانده شده است. [191]، گلاسرمن [114، 119]، پفلاگ [245] و روبینشتاین به همراه نویسندگان همکار مختلف [267، 268، 270]. این تکنگاری از نظر ساختار، انتخاب موضوعات و قالب آموزشی با منابع استاندارد ذکر شده متفاوت است. مخاطب ما دانشجویان تحصیلات تکمیلی و محققان هستند. ما با دقت مثالهای کاملی از کاربردها را بررسی کردهایم و مجموعهای از تمرینها و مسائل را گنجاندهایم که هدف آنها کمک به مدرسان و همچنین دانشجویان در هنگام مطالعه مطالب است. نظریه ریاضی، هنر مدلسازی و الگوریتمهای عددی هنگام حل مسائل واقعی مکمل یکدیگر هستند. ما این اصل را به عنوان فلسفه اساسی کتاب دنبال میکنیم و هدف آن تقویت مهارتهای نظری و عملی خوانندگان است که هیچ یک نباید بر دیگری غالب باشد. این کتاب دارای سه بخش اصلی است: • بخش اول، بررسی کاملی از روشهای مرتبه اول در بهینهسازی با تأکید بر تقریب تصادفی (SA) ارائه میدهد. نتایج کلیدی ارائه و اثبات شدهاند و مثالهای گویای زیادی ارائه شده است. بخش اول با مطالعه الگوریتمهای یادگیری بازگشتی از طریق معادلات دیفرانسیل معمولی (ODE)، رویکرد استاندارد در SA را دنبال میکند. در بخش اول، ما نهایت دقت را به کار میبریم تا تئوری و همچنین روشهای عددی را ارائه دهیم. دستورالعملهایی در مورد نحوه اعمال الگوریتمها در عمل، در بخش پایانی هر فصل با عنوان «ملاحظات عملی» گنجانده شده است که به تفصیل به بدهبستانهای معمول که در عمل با آنها مواجه میشویم، میپردازد. • بخش دوم، یک بررسی جامع از تخمین گرادیان است و تحقیقات انجام شده در این زمینه را در سه دهه گذشته خلاصه میکند. مثالهای زیادی ارائه شده و تئوری موجود به طور عمیق توضیح داده شده است. این بخش، ارائهای منحصر به فرد و جامع از تخمین گرادیان انتظارات تابعی فرآیندهای تصادفی ارائه میدهد. ما مدلها را از حالت «ایستا» یک متغیر تصادفی تا فرآیندهای تصادفی، از جمله مدلهایی با زمانهای توقف تصادفی و انتظارات ایستا بلندمدت (که گاهی اوقات در روششناسی شبیهسازی مدل «افق بینهایت» نامیده میشود) میسازیم. در اولین مطالعه، بخشهایی که با ستاره (*) مشخص شدهاند، ممکن است حذف شوند. • بخش سوم، نتایج الگوریتمی بخش اول را با تخمینگرهای گرادیان ارائه شده در بخش دوم ترکیب میکند و داستانهای کاملی از کاربردهای SA (از فرمولبندی مسئله گرفته تا انتخاب الگوریتم و تخمینگر گرادیان و تحلیل خروجی) ارائه میدهد. علاوه بر این، کاربردهای SA در سایر زمینههای تحقیقاتی مانند آمار و یادگیری ماشین مورد بحث قرار گرفته و برخی مطالب پیشرفته در مورد تحلیل اختلال بینهایت کوچک و مشتقگیری با مقدار اندازهگیری ارائه شده است.

This monograph covers stochastic optimization and learning, mostly focusing on the methodology of stochastic approximations and gradient estimation techniques.We focus on continuous parameter problems and do not discuss discrete optimization. Our approach is theoretical, but emphasis is given to algorithms that implement the methods. Part I covers many important applications of stochastic approximations for optimization and learning that do not require the use of gradient estimation. Part II introduces gradient estimation for stochastic processes, which then significantly broadens the range of application of stochastic approximations, some of which are described in Part III. Stochastic approximation has been intensively covered in the past decades. For general treatments of stochastic approximation, we refer toWasan [323], Polyak and Tsypkin [250], Ljung [205], Kushner and Clark [193], Polyak [248], Bertsekas and Tsitsiklis [32, 33], Bena¨ım [24, 25], Pflug [245], Kushner and Yin [197], Meyn [216], Borkar [39], and Nemirovski et al. [226]. Gradient estimation has been included in Ho and Cao [159], Cao [58, 60], Fu [101, 102], Kroese et al. [191], Glasserman [114, 119], Pflug [245], and Rubinstein with various coauthors [267, 268, 270]. This monograph differs from the aforementioned standard references in structure, choice of topics, and pedagogical format. We address an audience of graduate students and researchers. We have carefully worked out full examples of applications and have included a set of exercises and problems that aim to help the instructors as well as the students as they go through the material. Mathematical theory, the art of modeling, and numerical algorithms complement each other when solving real problems. We follow this principle as the underlying philosophy of the book, aiming to strengthen both the readers’ theoretical and practical skills, neither of which should dominate the other. The book has three main parts: • Part I provides a thorough treatment of first-order methods in optimization with an emphasis on stochastic approximation (SA). The key results are presented and proven, and many illustrating examples are provided. Part I follows the standard approach in SA by studying recursive learning algorithms via ordinary differential equations (ODEs).We take great care in Part I to present the theory and also the numerical methods. Guidelines on how to apply the algorithms in practice are included in a final section of each chapter called “Practical Considerations,” which addresses in detail typical trade-offs one faces in practice. • Part II is a self-contained treatment of gradient estimation and summarizes the research done in this area in the last three decades. Many examples are provided, and the available theory is explained in depth. It gives a unique, exhaustive presentation of gradient estimation of expectations of functionals of stochastic processes. We build the models from the “static” case of one random variable to stochastic processes, including models with random stopping times and long-term stationary expectations (called sometimes the “infinite horizon” model in simulation methodology). At a first reading, sections indicated by an asterisk (∗) may be omitted. • Part III blends the algorithmic results of Part I with the gradient estimators provided in Part II, and presents complete SA application stories (from problem formulation, to choice of algorithm and gradient estimator, to output analysis). Moreover, applications of SA in other field of research such as statistics and machine learning are discussed, and some advanced material on infinitesimal perturbation analysis and measure-valued differentiation is provided.

این کتاب را میتوانید از لینک زیر بصورت رایگان دانلود کنید:

Download: Optimization and Learning Via Stochastic Gradient Search

نظرات کاربران