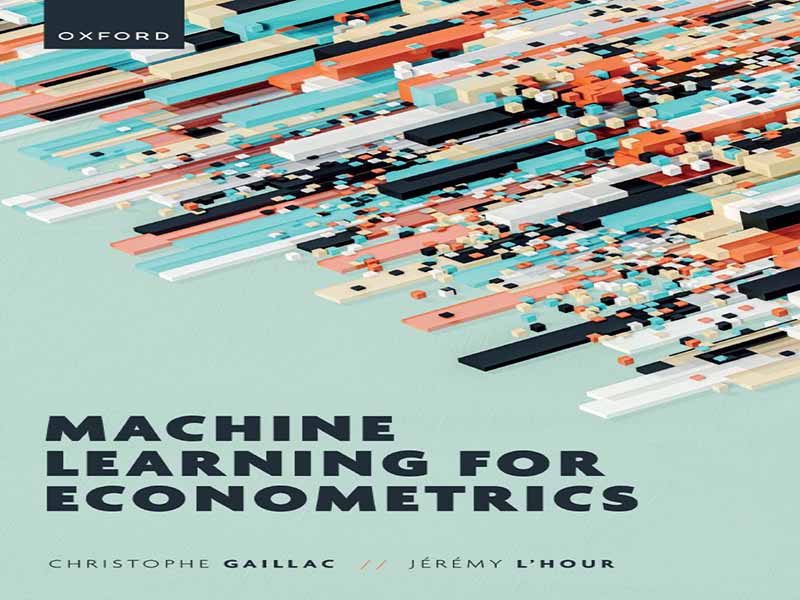

- عنوان کتاب: Machine Learning for Econometrics

- نویسنده: Christophe Gaillac, Jérémy LHour

- حوزه: یادگیری ماشین

- سال انتشار: 2025

- تعداد صفحه: 353

- زبان اصلی: انگلیسی

- نوع فایل: pdf

- حجم فایل: 14.1 مگابایت

اقتصادسنجی و یادگیری ماشین (ML) ابزارهای آماری مشترک زیادی دارند، همانطور که در فصل 2 خواهیم دید. با این حال، فلسفهها و اهداف این دو رویکرد اغلب به طرق ظریفی متفاوت هستند. برای ترسیم خطوط کلی این دو حوزه و ارائه ایدهای به خواننده از سوالاتی که آنها را به حرکت در میآورند، ابتدا تفاوتهای آنها را اغراق میکنیم. به خواننده یادآوری میکنیم که واقعیت بسیار ظریفتر است: هدف این کتاب درسی این است که ببینیم چگونه میتوانیم نیروهای یکی را برای دستیابی به اهداف دیگری مهار کنیم. اولین نقطه اختلاف در هدف این دو رویکرد نهفته است. اقتصادسنجی، قبل از هر چیز، با هدف کمّیسازی یک اثر دقیقاً تعریف شده است. به عنوان مثال: تأثیر افزایش حداقل دستمزد بر اشتغال چیست؟ آیا اثرات همتا در بین گروههای دانشجویی وجود دارد؟ میانگین شکاف دستمزد بین زنان و مردان چقدر است؟ به این معنا، اقتصادسنج بر یک یا چند پارامتر مورد علاقه تمرکز میکند تا تأثیری را که به دنبال اندازهگیری آن است، خلاصه کند. ما به طور خاص به استنباط آماری، یعنی ایجاد فواصل اطمینان و آزمایش فرضیهها، علاقهمند هستیم. به طور خاصتر، در طول سه دهه گذشته، اقتصاد تجربی بر اندازهگیری اثرات علی، نه فقط همبستگیها (Angrist and Pischke, 2010) تمرکز کرده است، تلاشی که با جایزه نوبل اعطا شده به جاشوا آنگریست، گویدو ایمبنز و دیوید کارد در سال 2021 و همچنین جایزهای که دو سال قبل به استر دوفلو اهدا شد، به اوج خود رسید. این الگو در فصل 3 مورد مطالعه قرار گرفته است. هدف اصلی اکثر مقالات اقتصادی، نشان دادن دقت استراتژی شناسایی آنها است، یعنی اثبات اینکه اثر اندازهگیری شده فقط ناشی از متغیر علی برجسته شده است و سایر پدیدههای انگلی را حذف میکند. از این رو، علاقه به آزمایشهای آزمایشگاهی، میدانی یا طبیعی یا جستجوی تغییرات برونزا در یک سیاست خاص، یعنی ایجاد شده توسط علتی مستقل از پدیده مورد نظر، وجود دارد. از سوی دیگر، هدف یادگیری ماشینی ساخت مدلی است که به فرد امکان میدهد بهترین عملکرد پیشبینیکننده ممکن را برای یک مسئله معین به دست آورد، که اغلب با رعایت یک محدودیت محاسباتی هنگام فراخوانی مدل، که به آن عملکرد زمان اجرا یا زمان استنتاج نیز گفته میشود، حاصل میشود. بنابراین، مدل باید پیشبینیها را در یک بازه زمانی مشخص تولید کند. محققان یادگیری ماشین اغلب در مورد الگوریتمها به جای مدلها صحبت میکنند تا تأکید کنند که این فرآیند مبتنی بر مجموعهای از دستورالعملها است که صرف نظر از ماهیت آنها، به یک پیشبینی منجر میشوند، نه بر اساس یک مدل آماری واحد. بنابراین، از یادگیری ماشین برای پاسخ به مسائل متفاوتی نسبت به مسائل اقتصادسنجی استفاده میشود، مانند ساخت سیستمهای پیشنهاد آهنگ یا فیلم، تطبیق جویندگان کار با شرکتها، ترجمه اسناد، پیشبینی نقطه داده بعدی در یک سری زمانی، دستهبندی محصولات، تشخیص الگوها در تصاویر، بازیابی اسناد بر اساس محتوای آنها و غیره. اصطلاح هوش مصنوعی (AI) اغلب به عنوان مترادف یادگیری ماشین استفاده میشود. این اصطلاح تأکید میکند که یک ماشین در انجام یک کار شناختی جایگزین انسان میشود و پیادهسازی آن میتواند در مقیاس بسیار بزرگ با هزینه حاشیهای بسیار کمی انجام شود – هزینههای ثابت اصلی شامل آموزش الگوریتم و سپس در دسترس قرار دادن آن است. به عنوان یک نکته دیگر، این هزینهها به هیچ وجه قابل اغماض نیستند، به طوری که آموزش مدلهای زبانی بزرگ (LLM) مانند مدلی که ChatGPT را از ابتدا پشتیبانی میکند، میتواند به بیش از چند میلیون دلار برسد. یادگیری ماشین حوزهای است که علم کامپیوتر در آن فراگیر است و مقایسه الگوریتمهای یادگیری ماشین با الگوریتمهای سنتی میتواند به درک تفاوتهای الگو کمک کند. الگوریتمهای سنتی شامل قوانین ثابتی هستند که از قبل توسط انسان ایجاد شدهاند و ماشین به سادگی آنها را اجرا میکند؛ در حالی که آموزش یک الگوریتم یادگیری ماشین شامل استفاده از مجموعه دادههایی است که ورودیها را به درستی با خروجیها مرتبط میکنند تا قوانین ضمنی زیربنای این ارتباطات را به کامپیوتر آموزش دهند، صرف نظر از ماهیت دقیق این قوانین، تا زمانی که پاسخهای مرتبطی برای کاربر نهایی (انسانی) تولید کنند. در مورد تجزیه و تحلیل دادههای متنی، این تفاوت بین استفاده از یک عبارت منظم (فصل 12) و یک مدل زبانی مدرن (فصل 14) است. قابل توجه است که یادگیری ماشین، و به ویژه یادگیری عمیق، چشمگیرترین موفقیتهای خود را در وظایف تعریفشدهای که با نسبت سیگنال به نویز مطلوب مشخص میشوند، به دست آوردهاند. چنین وظایفی، وظایفی هستند که اکثر انسانها قادر به انجام آنها هستند: تشخیص یک شیء در یک تصویر، یافتن مترادف یک کلمه، توصیه فیلمی که یک دوست از آن لذت خواهد برد و غیره. با این حال، دو مانع اصلی، اتوماسیون آنها را در مقیاس بزرگ مختل میکند: از یک سو، آنها در منابع شناختی حریص هستند و از سوی دیگر، به دلیل ماهیت بدون ساختار دادههای ورودی، فرمولبندی مجدد آنها به عنوان وظایف پیشبینی استاندارد چالش برانگیز است. فقدان ساختار در دادههای ورودی، ایجاد ویژگیها (متغیرهای توضیحی) یا ادغام آنها در چارچوبهای آماری مرسوم را چالش برانگیز میکند، زیرا آنها به طور مرتب در یک جدول قرار نمیگیرند، برخلاف دادههای جدولی که دانشمندان علوم اجتماعی به مقابله با آنها عادت دارند. این مورد است.

Econometrics and machine learning (ML) share many statistical tools, as we will see in Chapter 2. However, the philosophies and goals of these two approaches often differ in subtle ways. To draw the contours of the two fields and give the reader an idea of the questions that animate them, we will first exaggerate their differences. We remind the reader that the reality is much more nuanced: the purpose of this textbook is to see how we can harness the forces of one to achieve the goals of the other. The first point of divergence lies in the purpose of the two approaches. Econometrics, first and foremost, aims to quantify a precisely defined effect. For instance: what is the impact of a minimum wage increase on employment? Are there peer effects among groups of students? What is the average wage gap between women and men? In this sense, the econometrician focuses on one or a few parameters of interest aimed at summarizing the effect they seek to measure. We are particularly interested in statistical inference, i.e., building confidence intervals and testing hypotheses. More specifically, over the last three decades, empirical economics has focused on measuring causal effects, not just correlations (Angrist and Pischke, 2010), an effort crowned by the Nobel Prize awarded to Joshua Angrist, Guido Imbens, and David Card in 2021, as well as the one awarded to Esther Duflo two years earlier. This paradigm is studied in Chapter 3. The crux of most economics articles is to demonstrate the rigor of their identification strategy, i.e., to prove that the measured effect is due only to the highlighted causal variable, excluding other parasitic phenomena. Hence, the interest in laboratory, field, or natural experiments, or the search for exogenous variation in a particular policy, i.e., generated by a cause independent of the phenomenon of interest. On the other hand, the goal of ML is to build a model that allows one to obtain the best possible predictive performance for a given problem, often by respecting a computational constraint when calling the model, also called runtime or inference time performance. Thus, the model must generate predictions within a defined timeframe. ML researchers often talk about algorithms rather than models, to stress that this process is based on a series of instructions that lead to a prediction, regardless of their nature, rather than on a single statistical model. ML is therefore used to respond to different problems than those of econometrics, such as constructing song or movie recommendation systems, matching job-seekers to firms, translating documents, predicting the next data point in a time series, categorizing products, recognizing patterns in images, retrieving documents based on their content, etc. The term artificial intelligence (AI) is often used as a synonym for machine learning. This term underlines that a machine replaces the human in performing a cognitive task and that its implementation can be carried out on a very large scale at a very small marginal cost – the main fixed costs consisting of training the algorithm and then making it available. As an aside, these costs are far from negligible, so much so that training large language models (LLMs) like the one that powers ChatGPT from scratch can run to well over a few million dollars. Machine learning is an area in which computer science is ubiquitous, and comparing ML algorithms with traditional algorithms can help to understand the paradigm differences. Traditional algorithms consist of fixed rules, established a priori by a human, that the machine simply executes; whereas training an ML algorithm consists of using datasets that correctly associate inputs with outputs to teach the computer the implicit rules underlying these associations, regardless of the exact nature of these rules, as long as they produce relevant responses for the (human) end-user. In the case of analyzing text data, this is the difference between using a regular expression (Chapter 12) and a modern language model (Chapter 14). It is noteworthy that machine learning, and deep learning in particular, have achieved their most impressive successes in well-defined tasks characterized by a favorable signal-to-noise ratio. Such tasks are those that most humans are capable of performing: recognizing an object in an image, finding the synonym of a word, recommending a movie that a friend will enjoy, etc. However, two main roadblocks hinder their automation on a large scale: on the one hand, they are greedy in cognitive resources, and on the other hand, they are challenging to reformulate as standard predictive tasks due to the unstructured nature of the input data. The lack of structure in the input data makes it challenging to create features (explanatory variables) or to integrate them into conventional statistical frameworks because they do not neatly fit into a table, as opposed to tabular data social scientists are used to tackling. This is the case for images, for example, which are characterized by integer tensors representing pixels, but each pixel taken separately does not contain any information. Text is another case of unstructured data which can be represented as a sequence of integers that are uniquely mapped to tokens (pieces of words), which cannot be easily represented in a table because documents vary in length and word occurrences do not follow an auto-regressive process. Therefore, the capability to scale a task achievable by humans and to incorporate unstructured and highly complex data into a mathematical model fuels the current enthusiasm around ML. Its performance on tasks difficult to perform by a human being, because they might suffer from too high a level of noise or flagrant non-stationarities such as the prediction of macroeconomic series or stock prices, is yet to be demonstrated. To nuance this first difference between the two fields, we recall that forecasting is a well-known econometric subfield whose similarities with machine learning are very easy to see (Chapter 11). Nevertheless, econometric forecasting, because it often deals with complex phenomena, imposes a heavier constrained model. The goal is to counteract an unfavorable signal-to-noise ratio by injecting theoretical priors into models.

این کتاب را میتوانید از لینک زیر بصورت رایگان دانلود کنید:

Download: Machine Learning for Econometrics

نظرات کاربران